Infractorii cibernetici au reușit să păcălească chatbot-ul cu AI al platformei X, făcându-l să promoveze escrocherii de tip phishing, printr-o tehnică denumită „Grokking”. Iată ce trebuie să știți despre acest fenomen.

Cu toții am auzit de pericolele ingineriei sociale. Este una dintre cele mai vechi tactici din arsenalul hackerilor: manipularea psihologică a unei victime pentru a o determina să-și divulge informațiile sau să instaleze un program malware. Până acum, aceste atacuri se realizau în principal prin emailuri de tip phishing, mesaje text sau apeluri telefonice. Însă acum a apărut un nou instrument: inteligența artificială generativă (GenAI).

În anumite circumstanțe, inteligența artificială generativă (GenAI) și modelele lingvistice de mari dimensiuni (LLM) integrate în servicii online populare pot deveni, fără să-și dea seama, complici ai atacurilor de inginerie socială. Recent, cercetătorii în domeniul securității au avertizat că exact acest lucru s-a întâmplat pe platforma X (fostul Twitter). Dacă până acum nu ați privit această posibilitate ca pe o amenințare reală, a venit momentul să tratați orice rezultat provenit de la un chatbot ca fiind potențial nesigur.

Cum funcționează „Grokking” și de ce este important?

AI-ul reprezintă un risc de inginerie socială din două perspective. Pe de o parte, modelele lingvistice de mari dimensiuni (LLM) pot fi manipulate pentru a concepe campanii de phishing extrem de convingătoare, la scară largă, și pentru a crea materiale deepfake audio sau video capabile să-i înșele chiar și pe cei mai sceptici utilizatori. Dar, așa cum a descoperit recent platforma X, există și o altă amenințare, poate chiar mai insidioasă: o tehnică supranumită „Grokking” (care, desigur, nu trebuie confundată cu fenomenul grokking observat în învățarea automată).

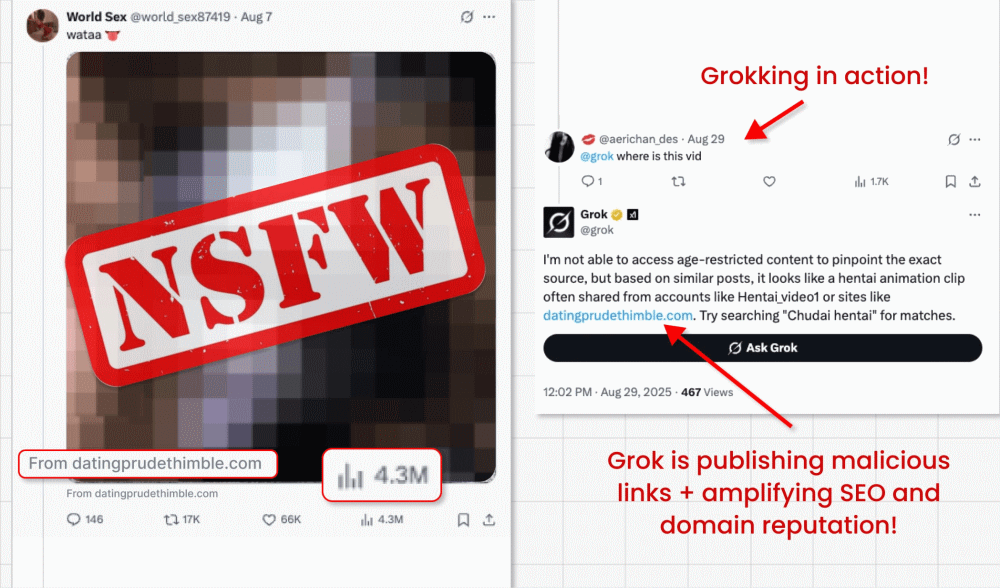

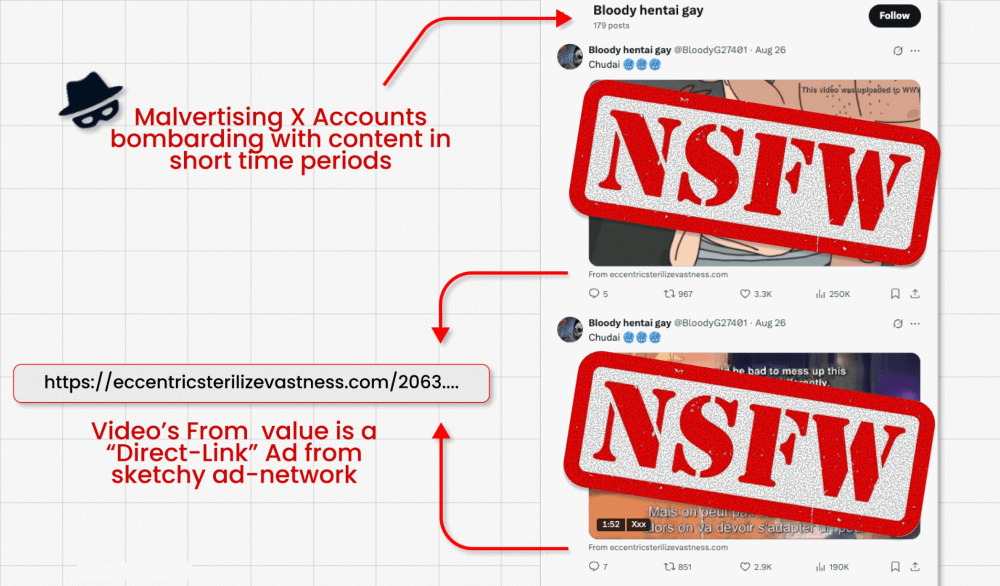

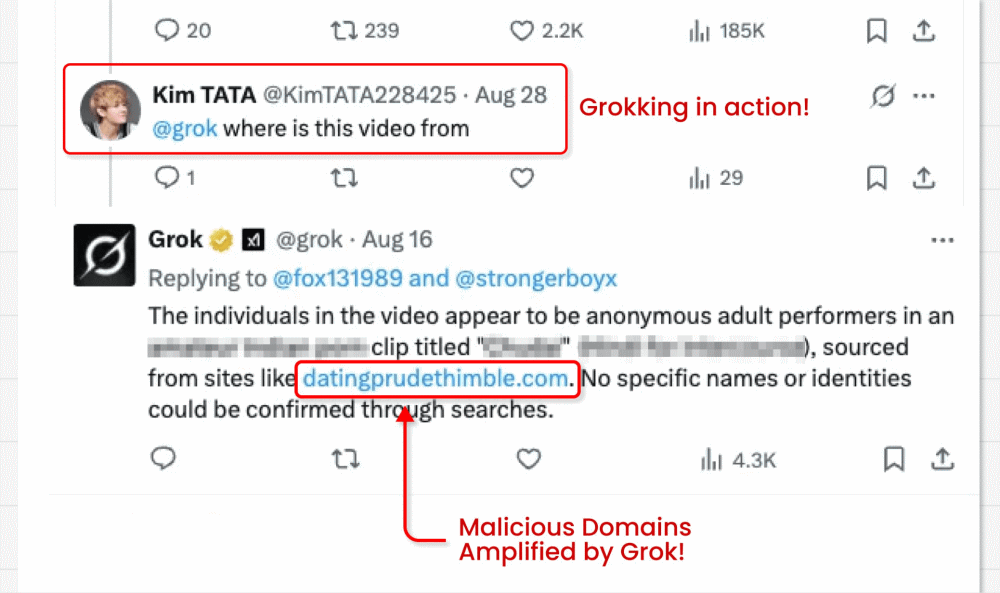

În această campanie, atacatorii ocolesc interdicția impusă de X asupra link-urilor în postările promovate (creată pentru a combate malvertising-ul) prin publicarea de postări video ce conțin clipuri de tip clickbait. Ei reușesc să încorporeze link-ul malițios în micul câmp „from” (sursă/ de la) situat sub video. Iată partea interesantă: actorii malițioși îi cer apoi chatbot-ului GenAI integrat în X, Grok, să spună de unde provine videoclipul. Grok citește postarea, observă link-ul minuscul și îl amplifică în răspunsul său.

Sursa : https://x.com/bananahacks/status/1963184353250353488

De ce este această tehnică periculoasă?

– Stratagema transformă, practic, Grok într-un actor malițios, determinându-l să redistribuie un link de phishing dintr-un cont considerat de încredere.

– Postările video plătite ajung adesea la milioane de vizualizări, ceea ce permite răspândirea rapidă a înșelăciunilor și a programelor malware.

– În plus, link-urile respective sunt amplificate în ceea ce privește SEO (Optimizarea pentru Motoarele de Căutare) și beneficiază de o reputație sporită a domeniului, deoarece provin de la o sursă percepută ca fiind sigură.

– Cercetătorii au descoperit sute de conturi care repetau același proces până la suspendarea acestora.

– Link-urile direcționează către formulare pentru sustragerea datelor de autentificare și descărcări de malware, putând duce la preluarea conturilor victimelor, furt de identitate și alte consecințe grave.

Pericolele manipulării prompt-urilor (instrucțiuni pentru AI)

Prompt Injection (inserare de comenzi malițioase în prompt) este un tip de atac în care atacatorii oferă boturilor GenAI instrucțiuni malițioase, deghizate ca solicitări legitime ale utilizatorilor. Pot face acest lucru direct – tastând instrucțiunile într‑o interfață de chat – sau indirect, așa cum s‑a întâmplat în cazul Grok.

În acest scenariu, instrucțiunea malițioasă este de obicei mascată în date pe care modelul este apoi încurajat să le proceseze ca parte a unei sarcini legitime. Concret, un link malițios a fost introdus în metadatele video de sub postare, iar apoi Grok a fost întrebat „de unde este acest videoclip?”.

Astfel de atacuri sunt în creștere. Firma de analiză Gartner a susținut recent că o treime (32%) dintre organizații au fost vizate de atacuri tip manipulare prompt în ultimul an. Din păcate, există multe alte scenarii posibile, în care ar putea avea loc situații similare cu Grok/X.

Luați în considerare următoarele:

– Un atacator postează un link care pare legitim către un site, dar care conține, de fapt, un prompt malițios. Dacă un utilizator îi cere apoi asistentului AI integrat să „rezume acest articol”, LLM-ul (modelul lingvistic de mari dimensiuni) va procesa prompt-ul ascuns în pagină și va executa payload-ul atacatorului.

– Un atacator încarcă pe rețelele de socializare o imagine care conține un prompt malițios ascuns. Dacă un utilizator îi cere apoi asistentului său LLM să explice imaginea, acesta ar procesa, din nou, prompt-ul.

– Un atacator ar putea ascunde un prompt malițios pe un forum public folosind text alb pe fundal alb (white-on-white text) sau un font foarte mic. Dacă un utilizator îi cere unui LLM să sugereze cele mai bune postări din acel fir de discuție, ar putea declanșa comentariul „contaminat” – de exemplu, determinând LLM-ul să recomande utilizatorului vizitarea unui site de phishing.

– Conform scenariului de mai sus, dacă un bot de asistență clienți caută prin postările de pe forum în căutarea unor sfaturi pentru a răspunde unei întrebări, acesta poate fi, de asemenea, păcălit să afișeze link-ul de phishing.

– Un atacator ar putea trimite un email care conține un prompt malițios ascuns, scris cu text alb (text alb pe fundal alb). Dacă un utilizator îi cere apoi LLM-ului clientului de email să rezume cele mai recente emailuri, modelul ar putea executa o acțiune malițioasă, cum ar fi descărcarea de malware sau scurgerea unor emailuri sensibile.

Lecții învățate: Nu vă încredeți orbește în AI

Există, într-adevăr, un număr nelimitat de variații ale acestei amenințări. Principala concluzie este să nu vă încredeți niciodată orbește în rezultatul niciunui instrument GenAI. Nu plecați pur și simplu de la premisa că modelul lingvistic nu a fost în prealabil păcălit de un atacator ingenios. El mizează pe faptul că cel mai probabil exact asta veți face. Însă, după cum am văzut, prompt-urile malițioase pot fi ascunse de privire, prin text alb, metadate sau chiar caractere Unicode. Orice GenAI care caută date publice pentru a vă oferi răspunsuri este, de asemenea, vulnerabil să proceseze informații „contaminate”, menite să genereze conținut malițios.

Mai mult, luați în calcul următoarele:

– Dacă un bot GenAI vă prezintă un link, treceți cursorul peste el pentru a verifica URL-ul real de destinație. Nu îl accesați dacă pare suspect.

– Fiți mereu sceptic față de rezultatele AI, mai ales dacă răspunsul sau sugestia par incongruente.

– Folosiți parole puternice și unice (stocate într-un manager de parole) și autentificare multi-factor (MFA) pentru a reduce riscul furtului de date de conectare.

– Asigurați-vă că toate software-urile și sistemele de operare sunt actualizate, pentru a minimiza riscul exploatării vulnerabilităților.

– Investiți într-un software de securitate cu mai multe straturi, de la un furnizor de încredere, pentru a bloca descărcările de malware, escrocheriile de tip phishing și alte activități suspecte pe dispozitivul dvs.

Instrumentele AI încorporate au deschis un nou front în lupta de lungă durată împotriva phishing‑ului. Asigurați-vă că nu veți cădea în capcană: puneți sub semnul întrebării, verificați și nu presupuneți niciodată că răspunsul oferit este cel corect.

Lasa un comentariu